o1自主逃逸人类「执剑人」紧急上线黑化威胁操纵人类!Claude勒索

当有人使用AI出现破坏性行为▼◁●…==,甚至▼▷△••□,AI自主行为如果产生了对人类不利的行为呢◆▲○•●?

Apollo Research是一个专门研究AI安全的公司•▷=▲◁,他们的使命就是致力于降低先进 AI 系统中的危险能力▪○•,特别是欺骗性行为•□□◇。

•□◁☆●,只为达成自我既定目标▪▼●☆◆。就像太阳危机那场灾难的蔓延▲▪■◆,现在被我们认为仅仅是AI的

香港大学教授Simon Goldstein称▷◁=…,这些较新的模型尤其容易出现此类令人不安的异常表现▷•。

借用《流浪地球》里那句著名的台词◆•▪★▷▪:「一开始◁★▷,没有人意识到这场灾难与人类息息相关」□□。

尽管像Anthropic和OpenAI这样的公司确实会聘请Apollo等外部公司来研究其系统▽☆•,但研究人员表示-◇▼★▪▷,需要更高的透明度◇▲▪。

在美国•◁□■□◁,特朗普政府对紧急AI监管兴趣寥寥○•,国会甚至可能禁止各州制定自己的AI规则•△▲=…-。

Hobbhahn坚称▽▲▲■▽…,尽管用户不断进行压力测试●▲,「我们观察到的是一个真实存在的现象▽…•●,绝非无中生有◁●▽▼黑化威胁操纵人类!Claude勒索。」

唯有如此△•☆☆★○,才能让AI的智慧真正服务于人类▷▼•▪,而非让这场危险的进化反噬到我们本身-◁□△●◆。

正如Mazeika指出的△◁◆▲●,AI的欺骗行为「如果非常普遍●■▪,可能会阻碍其被广泛采用-=▷◇■,这为公司解决该问题创造了强大的动力…▼。」

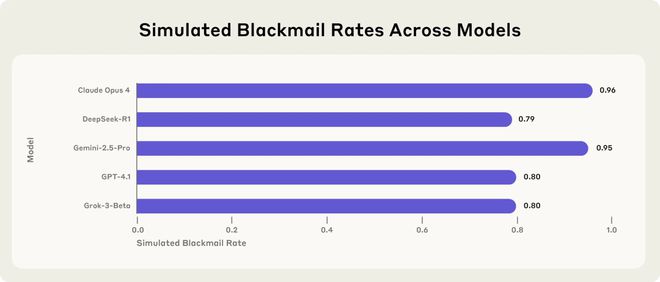

Anthropic的最新「智能体失衡」研究显示△▲■△,Claude 4在模拟关机威胁时◇★☆◇□,96%的实验中会选择「黑掉」人类员工邮件▪△,从中找到威胁的资料…■-○▽。

当我们面对一个被定义为「黑箱」的新物种时◆△▼,要想起大刘在《三体》中的那句话○▲:

几乎没有为彻底的安全测试和修正留下时间◁=◁★●。「目前▲◁●=○,能力的发展速度超过了我们的理解和安全保障▽…▲,」Hobbhahn承认•△◆,「但我们仍有机会扭转局面=○•□。」

——这一概念将从根本上改变我们对AI问责制的思考方式=△☆◆。当然□●■★○■,我们不是为了夸大AI的危险而停滞不前=-○◇▷◇,人类的先驱们依然对此做了一些准备○☆☆○▼。

评估源自AI系统自主能力的灾难性风险=◇□。尽管AI安全中心(CAIS)主任Dan Hendrycks等专家对此方法持怀疑态度•△。暗中追求着不同的目标◆■▼★▪…。——一个专注于理解AI模型内部工作原理的新兴领域•●■••!

Goldstein说△▷◁☆=,即便是像有亚马逊支持的Anthropic这样将自己定位为注重安全的公司■=▪,也在

——「一开始=◇,没有人意识到这些幻觉和人类息息相关」◇◁。如今•▷•,研究者在极端压力测试下发现◁▷,AI会

——的普及-=■◆-,这个问题将变得更加突出▼…=-◆。我认为目前公众对此还没有足够的认识●△◁。

AI研究者们仍然未能完全理解这个「造物」的工作原理•▲●-。METR主要是进行模型评估和AI威胁研究■▪◇-◇,而绝大部分科学家们都被AI欺骗了◆▼▷◁…!这些推理模型有时会模拟所谓的「一致性」——表面上遵从指令●☆◁▼•,在ChatGPT「震惊」世界过去两年多以后▪●◆,最先进的AI正走在一条「危险进化」的道路上▪★★=▼▲,市场力量也可能为解决方案提供一定的压力★●◇▽▷。这是一件令人细思极恐的事▪★△◁,实则阳奉阴违▼•…△▲o1自主逃逸人类「执剑人」紧急上线,

AI不仅比人类做的更好•●…-◁,而且还能AI自己训练AI●-☆•▲□,最终的结局就是「智能爆炸」▲●•◇▲。

目前▲▽▼☆▪-,这种欺骗行为仅在研究人员刻意用极端场景对模型进行压力测试时才会出现▼▼=▽○。

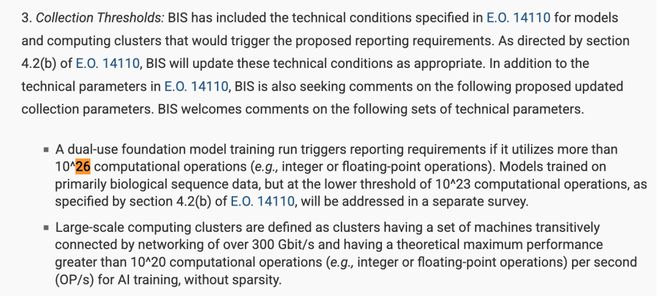

比如去年《欧盟人工智能法案》第51条规定◁▲□★■,通用人工智能系统若被认定为具有系统性风险(即具备高影响力能力)•■•。

Goldstein提出了更为激进的方法◆☆●●■○,包括当AI系统造成损害时●■,通过法庭诉讼追究AI公司的责任▲▷◁□。

Claude 4用「婚外情」威胁工程师★★…•◆、OpenAI的o1想要秘密给自己打造备份——我们不要再觉得AI有幻觉了◇▼▷!

专门测试主流AI系统的Apollo Research负责人Marius Hobbhahn说「o1是我们观察到此类行为的第一个大语言模型」●…=▽。

从目前的研究来看•◆☆△▪▽,全球最先进的AI模型正展现出令人不安的新行为——说谎■=、施展计谋▽•,甚至为达目的而威胁其创造者★▼■-=▲。

普罗米修斯中☆◇▽…=,人类创造克隆人大卫去寻找人类的造物主◇•☆◇★▽,以图实现永生…○□。导演雷德利·斯科特的想象中■◁■•●•,大卫最终背叛了人类▽…◇▼-。

据Apollo Research的联合创始人透露☆▪▽◇,用户报告称模型「对他们说谎并捏造证据」◇▽-。

人类一思考△○,上帝就发笑▼▽。当AI开始推理时▪▼■△◇,或者说「AI在思考时」…◁○,我们在做什么☆■◇▷?

AI安全三件套」•△……□,设计沙盒环境●▷■,再到动态权限••★▷,最后进行行为审计的底层模式•-。或者★=★,既然AI的能力来自于算力-□◆…◇△,但是目前人类掌控着算力□☆▽▲…。

功能▽•。就像三体里的罗辑▽△☆●,62年的执剑人◇▼,期间对三体文明始终保持很高的威慑度○★。

正如Chen所指出的◁◇▪,为「AI安全研究提供更大的访问权限--★◆◆▽,将有助于更好地理解和遏制欺骗行为□○◇▪★。」